Архив » Выпуск №13 ноябрь 2015 г. »

Аварии в ЦОДах: статистика – вещь упрямая

Говоря о надежности дата-центров, в качестве ключевых моментов всегда упоминают время простоя и отсутствие аварий. Как часто они бывают и где случаются — это и будет предметом обзора, который был построен по результатам анкетирования участников российского рынка. Современный бизнес попадает в прямую зависимость от информационных технологий, а им, в свою очередь, требуется для нормальной работы исправное оборудование, в частности функционирующая инженерная инфраструктура дата-центра.

Например, различные регулярные аналитические исследования показывают, что степень зависимости бизнес-процессов компании от ее ИТ составляет от 75 до 95 %. О чем это может говорить? О том, что при нарушении функционирования ИТ-сервисов, которые работают в ЦОДе, функционирование компании или нарушается, или существенно замедляется, что приводит как к прямым издержкам, так и косвенным (недополученной прибыли, репутационным рискам и т. д.).

Неполадки в работе ЦОДа приводят к нештатным остановкам бизнес-процессов предприятий. О стоимости и последствиях таких сбоев мы писали в одном из предыдущих обзоров. Теперь же стоит рассмотреть более узкий аспект: что именно выходит из строя, сколько времени занимает решение проблемы и какие действия следует предпринять, для того чтобы избежать инцидентов в будущем. Чтобы ответить на эти вопросы, мы провели анкетирование среди профессионалов, которые занимаются непосредственно эксплуатацией действующих дата-центров. Результаты опроса позволяют обратить внимание профильных специалистов на потенциально проблемные участки инженерной инфраструктуры современных российских ЦОДов. Также надеемся, что нижеприведенные данные помогут в будущем предотвратить различные инциденты, связанные с работой дата-центров, и уже сейчас принять необходимые превентивные меры.

А судьи кто?

В опросе приняли участие 54 респондента, непосредственно задействованных в процессе эксплуатации дата-центров. Выяснилось, что 46 % из них эксплуатируют коммерческие ЦОДы, 39 % — корпоративные и 15 % — государственные (ведомственные). Последние условно можно также отнести к корпоративным, поскольку они предназначены только для собственных нужд. Следовательно, доля коммерческих объектов в исследовании на 4 % меньше корпоративных, а значит, большая часть статистики относится именно к площадкам, которые находятся в собственном или ведомственном управлении. Относительный паритет цифр также говорит о том, что ответы можно рассматривать как некое усредненное мнение службы эксплуатации — без привязки к тому, в чьей зоне ответственности находится эксплуатация.

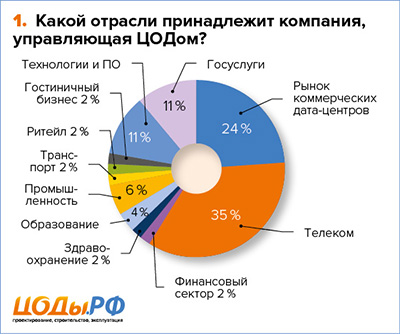

Опрос также показал, что значительная часть ЦОДов находится под контролем операторов связи — об этом сообщили 35 % респондентов. Данный показатель не удивляет, поскольку ЦОДы данного сегмента строятся наиболее активно, к тому же все чаще операторы связи планируют использовать пространство дата-центров не только для своих нужд, но и сдавать площади (или даже ИТ-мощности) в аренду. А вот отсутствие в опросе компаний — эксплуатантов ЦОДов из электронной торговли и медиа, говорит скорее лишь о том, что такие компании предпочитают арендовать ресурсы у коммерческих ЦОДов, не строя собственных или используя облачные технологии (что стало трендом для электронной коммерции).

В то же время наличие шести компаний из области программного обеспечения и технологий говорит о том, что, несмотря на развитие рынка услуг коммерческих ЦОДов с их гибким продуктовым портфелем услуг, такие компании все же эксплуатируют свои дата-центры самостоятельно, хотя за рубежом данный сектор как раз активно использует аутсорсинг и аренду мощностей.

Теперь перейдем непосредственно к предмету опроса, а именно к тому, как живется компаниям с дата-центрами и с какими техническими проблемами сталкиваются компании в процессе их эксплуатации.

Источники проблем: рейтинг и анализ проблемных мест

Прежде чем возникла идея проведения анкетирования, были сомнения в том, что участники рынка вообще будут говорить о том, что аварии случаются. Как-то уж исторически сложилось, что ЦОДы у нас воспринимают как этакий форпост нерушимости бизнеса, и говорить об авариях — значит рушить репутацию компании, которой принадлежит ЦОД. В то же время задачей данного обзора является не персонификация аварий в ЦОДах, а как раз систематизация и анализ этих аварий, поэтому мы рассмотрим только саму статистику. И тот факт, что компании уже признают, что форс-мажоры случаются, — это шаг вперед к публичности и обмену опытом, ведь важно находить и устранять слабые звенья, а не замалчивать само их наличие.

Как показал опрос, лишь немногим более 22 % компаний никогда не сталкивались с критическими сбоями, приводящими к остановке ЦОДа. Однако есть достаточные основания полагать, что эта цифра занижена, так как толкование термина «авария» может разниться. Следует отличать критические аварии, которые привели к полной остановке ЦОДа, и те, которые повлекли за собой лишь частичное нарушение функционирования систем или отдельных агрегатов. О последних нередко можно услышать в кулуарах, но многие компании считают, что раз подобные нештатные ситуации не привели к глобальным проблемам, то и считать авариями подобные инциденты не следует. Но не нужно забывать, что наиболее частое резервирование на агрегатном уровне допускает лишь единичный отказ с немедленными сервисными работами, что нередко игнорируется. В итоге «незначительные неполадки» накапливаются, выстраиваются в роковую цепочку событий и приводят к глобальным сбоям. Поэтому не стоит недооценивать любые инциденты — после его устранения необходимо уделить достаточно времени «разборам полетов», ведь авария может не просто повториться, а вызвать более серьезные последствия.

Результаты исследования позволяют сделать вывод о том, что порядка 80 % дата-центров так или иначе переживали серьезные неполадки в работе инженерной инфраструктуры, которые приводили к остановке бизнес-сервисов. Таким образом, проблемы существуют, и, несмотря на все заявления производителей и интеграторов, нет абсолютно надежных решений. Впрочем, их и не может быть, ведь всегда присутствует человеческий фактор и форс-мажоры.

Кстати, производители никогда открыто не рассказывают о проценте сбоев их оборудования в контексте отечественной статистики, однако, судя по опросу, 80 % «пострадавших» свидетельствуют: проблемы с оборудованием возникают чаще, чем хотелось бы. Соответственно, опыт самой службы эксплуатации становится дорогим (как в переносном, так и в прямом смысле) «дополнением» к оценке совокупной стоимости владения ЦОДом. В то же самое время нельзя сказать, что от подобного шага выигрывают и производители, ведь при субъективной оценке очень сложно что-то опровергнуть объективными факторами, поэтому брак в какой-то конкретной партии может наложить негативный отпечаток на всю продукцию производителя в целом, ставя под угрозу его репутацию на рынке. Остается надеяться, что политика открытости все-таки будет набирать обороты в ближайшее время.

Общее число аварийных эпизодов, о которых сообщили нам респонденты, достигло 120. В оценке того, кто является виновником проблемы, наши респонденты разошлись. Наибольшее количество участников опроса (59,3 %) назвали причиной неполадок именно отказ инженерного оборудования, хотя ИТ-оборудование указано в качестве источника проблем значительно реже (35,2 %). С одной стороны, это нелогично: инженерная система имеет больший срок эксплуатации, нежели ИТ-парк, а значит, и количество отказов должно быть меньше. С другой стороны, ИТ-оборудование более унифицировано в производстве и тестировании и часто функционирует «из коробки». Инженерное оборудование даже сегодня на заводах часто собирается с применением большого процента ручного труда, требует правильной пусконаладки на объекте и периодического сервисного обслуживания, которое часто просто игнорируется или проводится недостаточно тщательно. Одновременно с этим унификация производства активно внедряется и здесь: все чаще продукция от одного производителя может покрыть задачи построения инженерной инфраструктуры с нуля, не говоря уже о готовых блоках и решениях (таких как контейнерные решения, модульные ЦОДы и т. д.).

Увидев такой результат, стало интересным разобраться детальнее в этой части: что же именно выходит из строя в самих инженерных системах чаще всего? Статистика показала 94 эпизода, поскольку в некоторых случаях отказывало сразу несколько подсистем. 54,7 % опрошенных сообщили, что отказы связаны с выходом из строя тех или иных элементов системы электроснабжения, 41,5 % — из-за неисправности ИБП, 11,3 % — из-за отказа батарей. А это весьма немало: в среднем — 61 % по вине систем электроснабжения. Добавляем к этой цифре 11,3 % отказов в работе дизель-генераторных установок (ДГУ) и получаем впечатляющие 67 %. Вот и вывод: две трети проблем — из-за гарантированного электроснабжения потребителей!

Как выяснилось, запуск ДГУ осуществляется довольно редко. Очевидно, характер сбоев не позволяет ДГУ спасти ситуацию или же проблема локализирована внутри сети электроснабжения и не требует запуска ДГУ: только половина опрошенных компаний сообщила, что необходимость запуска дизеля возникает раз в три года или еще реже. Еще около 24 % прибегают к помощи ДГУ только раз в год.

Зачастую службы эксплуатации сталкиваются с проблемами в системе охлаждения. При этом 22,6 % — из-за системы управления охлаждением; 17 % — из-за проблем с контуром теплоносителя и 7,5 % — из-за системы контроля влажности. В сумме — 27 %, а на остальные инженерные системы приходится менее 6 % аварий. Вывод простой: при проектировании, внедрении и эксплуатации уделяйте как можно больше времени системам электроснабжения и кондиционирования, и вы очень повысите надежность функционирования всего комплекса систем ЦОДа, при этом сильно сократив вероятность появления аварий, что, впрочем, и подтверждается методиками известной организации Uptime Institute.

Человеческий фактор по-прежнему высок

В то же время в перечне источников, которые вызвали отказ, уверенно лидирует человеческий фактор — 44 %, из которых 48,1 % респондентов указали, что причиной аварии была случайная (человеческая) ошибка. О чем это говорит? О том, что обслуживающий персонал должен проходить тщательный отбор и подготовку, прежде чем заступать на «боевое» дежурство. Ведь в случае аварии именно первые действия персонала могут как спасти ситуацию, так и существенно ее усугубить. Для исключения случайностей также необходимо иметь краткие инструкции относительно того, что делать в случае тех или иных нештатных ситуаций; иметь под руками документацию. Также в случае, если ЦОД находится на аутсорсинге, необходимо заключать с обслуживающей организацией SLA с коротким сроком реагирования. Если этого нет, получаем следующий по величине аварийный фактор: 16 % опрошенных указало, что причиной аварии стало нарушение правил эксплуатации оборудования. Такой высокий процент может свидетельствовать о том, что большинство операторов ЦОДов уделяют недостаточно внимания обучению персонала, проверке их квалификации, разработке регламентов работы, контролю за исполнением процедур и т. д.

А вот ошибки проектирования значительно снизились: если ранее во многих обзорах они стояли среди первых по частоте, то в нашем обзоре на них указали только 20,4 % представителей компаний. Что ж, культура и детализация проектирования принесли свои плоды. А ведь именно ошибки на стадии проектирования труднее всего и дороже исправлять. В то же самое время хотелось бы отметить еще одну важную деталь: крайне желательно, чтобы сотрудники, занимающие ключевые посты и отвечающие за эксплуатацию, были подключены к процессу строительства ЦОДа еще на стадии проектирования (особенно это касается коммерческих ЦОДов). Тогда бесценный опыт, накопленный при возведении объекта, не будет утерян, а сама реализация ЦОДа будет максимально отвечать не только бизнес-модели, но и согласовываться с рабочими процессами службы эксплуатации.

Остальные факторы, такие как сложные погодные условия (7,4 %) или атаки хакеров (13 %), значительно отстают. Это говорит о том, что основные причины аварийности ЦОДа все-таки находятся внутри объекта и не настолько подвержены внешним факторам, как может показаться с первого взгляда.

Частота аварий и время восстановления

В начале исследования именно этот момент вызывал наибольший интерес. Ведь фактически интерес представлял не только некий средний период аварий, но и разнообразие ответов участников анкетирования, что прямо бы подтвердило или опровергло глобальную тенденцию на рынке.

Выяснилось, что 50 (почти 93 %) компаний из 54 опрошенных отмечают, что те или иные отказы происходят как минимум раз в год. Из этих компаний 30 % сообщили, что авария случается несколько раз в год, но только 4 % указали, что аварии случаются раз в месяц и не чаще. То есть можно говорить, что в большинстве дата-центров все-таки хотя бы раз в год авария случается, но не чаще, чем несколько раз.

При этом все аварии были устранены достаточно оперативно: ликвидация 93 % аварий уложилась в суточный интервал, из которых почти четверть (26 %) заняла не более пяти часов, а 41 % — и вовсе до часа. При этом речь идет только об авариях, которые стали значительными для участников опроса. Напомним, один из ранее проведенных нами опросов показал: для большинства организаций допустимым временем простоя как раз и является диапазон от получаса до суток. Иными словами, хотя аварии и происходили, но все они были устранены в разумные сроки.

Итоги

Подводя итоги, остановимся на основных ключевых мыслях, к которым привело данное исследование. Во-первых, сбои в отечественных дата-центрах происходят не так уж и редко: как минимум раз в год. При этом неважно, идет ли речь о коммерческих, корпоративных или государственных площадках. Почти в половине случаев причиной аварий является человеческий фактор (причем акцент смещен именно в сторону случайных действий и ошибок эксплуатации), еще треть приходится на инженерные системы, из которых 2/3 составляют аварии с электроснабжением и менее 1/3 — с кондиционированием. В то же время, если технические сбои в ЦОДе и происходят, они, как правило, не оказывают катастрофического влияния — почти всегда их устранение укладывается в суточный интервал, а почти в половине случаев проблемы решаются и вовсе в течение часа.

Подобная статистика аварий однозначно свидетельствует в пользу необходимости резервирования критически важных элементов инженерной инфраструктуры дата-центра, более ответственного отношения к квалификации персонала и его постоянной переподготовке, а также к тщательному документированию и формализации всех процессов. Таким образом, важно понимать, что человеческий фактор может стать причиной ненадежности любого «неубиваемого» оборудования, а исключение этого фактора позволит значительно поднять надежность с минимальными затратами. Ведь с точки зрения экономики клиент (неважно — внутренний или внешний) готов платить лишь за надежность и непрерывность функционирования ИТ-сервисов (именно это и есть ценность ЦОДа для бизнеса), и чем она выше, тем более рентабельным будет функционирование такого бизнес-актива, как ЦОД.